Pojęcie sztucznej inteligencji (Artificial Intelligence) znane jest od lat 50. XX w. Jednak dopiero w ostatnich latach jej wykorzystanie do rozwiązywania problemów w sposób niealgorytmizowany, w oparciu o posiadane zasoby danych, rozwija się błyskawicznie i znajduje coraz częściej praktyczne zastosowanie. „Zdolność do uczenia się” i „samodzielne rozwiązywanie problemów” – bez korzystania z zaprogramowanych wcześniej algorytmów – to najczęściej wymieniane cechy sztucznej inteligencji.

Sztuczna inteligencja znajduje zastosowanie w przeważającej części dziedzin gospodarki, począwszy od diagnostyki medycznej, przez handel i e-commerce, szeroko rozumiany przemysł, usługi bankowe i ubezpieczeniowe, transport osób i towarów, logistykę, a skończywszy na inteligentnych miastach i pojazdach.

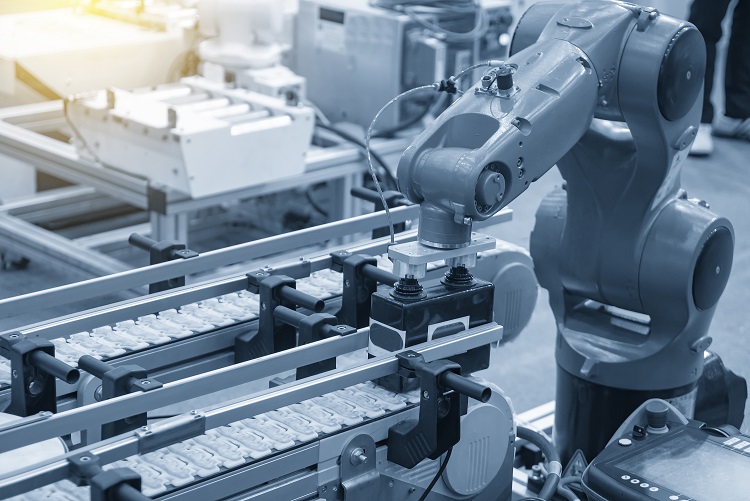

Sztuczna inteligencja, w tym sieci neuronowe są również coraz szerzej używane przez projektantów układów automatyki. Praktyczne wykorzystanie tych technologii w automatyce to głównie zastosowanie w modelowaniu i sterowaniu obiektami przemysłowymi. Wykorzystywanie sztucznej inteligencji w tej dziedzinie to m.in. „uczenie się” maszyn oraz przewidywanie błędów i awarii systemów. Może to poprawić wydajność systemów i zapobiegać przestojom produkcji, ale również zwiększyć wydajność dzięki algorytmom uczenia się w oparciu o zasoby danych.

W artykule przedstawiamy podstawowe zagadnienia natury prawnej związane z wdrożeniem i wykorzystywaniem sztucznej inteligencji, która coraz częściej jest przedmiotem zainteresowania prawników. Zainteresowanie ma na razie sferę czysto teoretycznej, ponieważ dotychczas nie została podjęta inicjatywa ustawodawcza mająca na celu uregulowanie problemów związanych ze sztuczną inteligencją. Organizacje międzynarodowe, jak również ustawodawcy krajowi, ograniczają się do politycznych deklaracji oraz strategii rozwoju dotyczących sztucznej inteligencji.

Podstawowym zagadnieniem rozważanym przez prawników jest możliwość autonomicznego działania sztucznej inteligencji w sferze prawnej, tj. zdolność występowania sztucznej inteligencji w stosunkach prawnych jako podmiotu prawa. Wyzwania prawne wiążące się z wdrożeniem i wykorzystaniem sztucznej inteligencji są różnego rodzaju. Szczególną uwagę należy zwrócić na kwestie odpowiedzialności za szkody wyrządzone przez systemy oparte na sztucznej inteligencji oraz zasady przetwarzania danych osobowych przez takie systemy.

Odpowiedzialność za działanie sztucznej inteligencji

Podstawową cechą sztucznej inteligencji jest rozwiązywanie złożonych problemów w oparciu o zgromadzone zasoby danych, wyciąganie wniosków oraz samodzielne (autonomiczne) podejmowanie decyzji dla osiągnięcia z góry założonego przez programistę czy dysponenta celu. Niezależny od twórcy rozwój sztucznej inteligencji w połączeniu z autonomicznością jej działania może sprawiać, że decyzje podejmowane przez takie systemy będą trudne do przewidzenia oraz uzasadnienia, zarówno przez twórcę rozwiązania (np. programistę pierwotnych algorytmów), jak również użytkownika. Pojawia się zatem pytanie o skutki „decyzji” podjętych autonomicznie przez sztuczną inteligencję oraz odpowiedzialności za nie.

Nietrudno wyobrazić sobie sytuacje, w których efektem błędnych decyzji autonomicznych systemów opartych na sztucznej inteligencji będą różnego rodzaju szkody. Wszyscy słyszymy o wypadkach spowodowanych przez autonomiczne pojazdy, ale szkody mogą wiązać się również z błędnymi diagnozami medycznymi, spadkiem wydajności systemów produkcyjnych, stratami finansowymi spowodowanymi przez systemy wspierane sztuczną inteligencją, stratami wynikającymi z błędów inwestycyjnych programów wspierających inwestorów giełdowych czy szkodami spowodowanymi przez systemy wykorzystywane do zarządzania w energetyce.

Kto w takich przypadkach powinien odpowiadać za powstałe szkody? Czy powinni to być twórcy pierwotnych algorytmów sztucznej inteligencji, producenci urządzeń sterowanych systemami wspieranymi sztuczną inteligencją, czy podmioty dysponujące systemem i zasilające go danymi, czy sztuczna inteligencja jako autonomiczny podmiot prawa?

Teorie w tym zakresie są różne. Jedną z nich jest postulat nadania najbardziej rozwiniętym systemom autonomicznym specjalnego statusu prawnego – tzw. „osoby elektronicznej”. Powstałaby w ten sposób odrębna kategoria podmiotów prawa, ze zdolnością prawną i zdolnością do czynności prawnych, w ograniczonym lub pełnym zakresie – zdolna do samodzielnego funkcjonowania w obrocie prawnym, zdolna do zaciągania zobowiązań i dochodzenia roszczeń oraz odpowiedzialna za skutki własnych decyzji. Ten pomysł, na obecnym etapie rozwoju systemów autonomicznych, jest jednak krytykowany, choć już w 2017 r. humanoidalny robot o imieniu Sophie otrzymał obywatelstwo Arabii Saudyjskiej.

Jak rozwiązać problem odpowiedzialności w razie spowodowania szkody przez urządzenia sterowane sztuczną inteligencją, w przypadku spełnienia przesłanek odpowiedzialności określonych w przepisach ogólnych, tj. wystąpienia zdarzenia, z którym łączy się obowiązek naprawienia szkody, powstaniem samej szkody oraz związkiem przyczynowym między zdarzeniem a szkodą? Jak w takich przypadkach określić podmiot odpowiedzialny za powstałą szkodę?

Jeśli przyjmiemy, że sztuczna inteligencja jest „rzeczą” w rozumieniu przepisów prawa cywilnego, wówczas dysponent posługujący się takim narzędziem powinien ponosić odpowiedzialność za skutki jej działania. Traktowanie sztucznej inteligencji jako narzędzia w rękach jej dysponenta umożliwia jednoznaczne i łatwe określenie podmiotu odpowiedzialnego. Jednak w przypadku wysoko rozwiniętej sztucznej inteligencji dysponent ma ograniczony wpływ na „autonomiczne” decyzje podejmowane przez takie rozwiązania. Czy zatem przyjęcie takiego modelu odpowiedzialności nie będzie krzywdzące dla dysponentów systemów wspieranych sztuczną inteligencją?

Możliwe jest również przyjęcie koncepcji odpowiedzialności za działania sztucznej inteligencji na zasadzie winy w nadzorze, czyli sytuacji, gdy dysponent odpowiedzialny za nadzorowanie działania systemów lub urządzeń opartych na sztucznej inteligencji nie dopełni obowiązków nadzoru jej działania. Takie założenie umożliwia osobie nadzorującej uchylenie się od odpowiedzialności, np. w przypadku działania osób trzecich czy siły wyższej. Jest to koncepcja bardziej korzystna dla dysponentów sztucznej inteligencji niż w modelu, w którym właściciele traktowani są jak sprawcy szkody.

Należy także wspomnieć o odpowiedzialności na zasadzie ryzyka, przewidzianej przez przepisy ogólne prawa cywilnego. Zasada ta ma zastosowanie np. w przypadku szkód powstałych przez zawalenie się budowli, będących wynikiem prowadzenia na własny rachunek przedsiębiorstwa lub zakładu wprawianego w ruch za pomocą sił przyrody czy wyrządzonych przez produkt niebezpieczny.

Najbardziej adekwatne, w odniesieniu do odpowiedzialności za szkody wyrządzone przez sztuczną inteligencję, jest wykorzystanie modelu odpowiedzialności za produkt niebezpieczny. Przy zastosowaniu tego modelu odpowiedzialność za szkody wyrządzone przez sztuczną inteligencję obciążałaby producenta. Roszczenie odszkodowawcze od producenta przysługiwałoby poszkodowanej osobie, która wykazałaby wady rozwiązania sztucznej inteligencji, doznaną szkodę oraz związek przyczynowy między wadą a szkodą. Również w tym modelu producent może wykazać okoliczności wyłączające jego odpowiedzialność. Przykładowo może wykazać, że wada nie istniała w momencie wprowadzenia „produktu” do obrotu lub powstała później albo udowodnić, że szkoda powstała z wyłącznej winy poszkodowanego.

Szczegółowe omówienie modeli i zasad odpowiedzialności za szkody powstałe w wyniku stosowania sztucznej inteligencji przekracza możliwości przedstawienia w niniejszym artykule. Niewątpliwe skutecznym rozwiązaniem dla uniknięcia ryzyka jest ubezpieczenie od skutków działania sztucznej inteligencji. Ubezpieczenie takie może uchronić zarówno producentów, jak i dysponentów sztucznej inteligencji. Podnoszone są również propozycje wprowadzenia obowiązkowego ubezpieczenia stosowania sztucznej inteligencji – na wzór obowiązkowego ubezpieczenia OC właścicieli pojazdów.

Dane osobowe

Rozwój sztucznej inteligencji, czyli zdolności uczenia się i samodzielnego podejmowania decyzji, możliwy jest dzięki pracy na zbiorach danych, wśród których mogą znajdować się również dane osobowe. W wielu przypadkach może również dochodzić do przetwarzania danych polegającego na profilowaniu osób fizycznych, np. w formie analizowania i prognozowania ich osobistych preferencji i zachowań. W takiej sytuacji konieczne jest spełnienie szeregu warunków i obowiązków wynikających z przepisów ogólnego rozporządzenia o ochronie danych – RODO.

W pierwszej kolejności należy poinformować osoby, których dane są przetwarzane o fakcie profilowania oraz o konsekwencjach takiego profilowania. W przypadkach, gdy w wyniku profilowania dochodzi do zautomatyzowanego podejmowania decyzji względem tych osób, należy wskazać informacje o zasadach profilowania i podejmowania decyzji, a także o znaczeniu i przewidywanych konsekwencjach takiego przetwarzania dla osoby, której dane dotyczą. Osoby, których dane są profilowane mają prawo do wniesienia w określonych okolicznościach sprzeciwu wobec takiego przetwarzania danych, o czym powinni zostać również poinformowani. Należy mieć na uwadze powyższe okoliczności przed podjęciem decyzji o wdrożeniu systemu opartego na sztucznej inteligencji czy wykorzystującego ją oraz przed wyborem podmiotu dostarczającego rozwiązanie. Konieczne jest prawidłowe uregulowanie zasad współpracy z dostawcą systemu, w szczególności w zakresie zasad odpowiedzialności w przypadku naruszenia zasad przetwarzania danych osobowych, np. w wyniku błędnej decyzji podjętej przez system sztucznej inteligencji. Niezbędna w tej sytuacji będzie umowa powierzenia przetwarzania danych osobowych, która szczegółowo ureguluje zasady powierzenia danych wykonawcy oraz jego odpowiedzialności w tym zakresie.

Podsumowanie

Zastosowanie sztucznej inteligencji oraz jej wpływ na tempo wzrostu gospodarczego nie jest kwestionowane. Korzyści, nie tylko ekonomiczne, będą skłaniać do coraz szerszego wykorzystania sztucznej inteligencji w różnych dziedzinach życia i aktywności człowieka. Będzie to jednak wiązać się z szeregiem wyzwań natury prawnej, a jak zwykle rozwój regulacji i praktyki prawa nie nadąża za błyskawicznym rozwojem technologii. W miarę dalszego rozwoju oraz uniezależniania się systemów opartych na sztucznej inteligencji niewątpliwie konieczne będzie podjęcie kroków legislacyjnych w celu dostosowania przepisów do nowej rzeczywistości. Dotyczy to wielu aspektów – począwszy od próby określenia statusu prawnego sztucznej inteligencji oraz modelu odpowiedzialności za szkody przez nią wyrządzone, po zmiany w przepisach szczegółowych regulujących konkretne dziedziny życia – np. w zakresie odpowiedzialności za błędy medyczne lub szkody spowodowane przez autonomiczne pojazdy czy systemy zarządzające produkcją.

Artykuł ukazał się w Miesięczniku Automatyka, wydanie 9/2021. – https://automatykaonline.pl/Automatyka/Roczniki/2021/9-2021

Autor: Maciej Dudek, radca prawny